Vocageek #48 : pourquoi une IA « hallucine » ?

Il n’y a pas que les êtres humains qui peuvent halluciner. Les Intelligences Artificielles génératives comme ChatGPT ou Gemini hallucinent aussi ! Et, même si on ne parle pas exactement de la même chose, que des IA puissent se tromper ou même inventer des faits dans leurs réponses est un vrai problème qu’il faut prendre en compte quand tu les utilises !

Pour découvrir d’autres termes sur les technologies du numérique, va sur notre page spéciale Vocageek !

La définition

Les hallucinations se produisent lorsque le modèle d’IA produit des informations incorrectes, trompeuses ou inventées de toutes pièces. Ce phénomène peut survenir dans divers systèmes d’IA générative, notamment les générateurs de texte, les créateurs d’images, etc.

Pas exactement comme les humains

Ce phénomène est appelé « hallucination » par analogie avec le phénomène de l’hallucination en psychologie humaine. Une différence clé est que l’hallucination humaine est généralement associée à de fausses perceptions, alors qu’une hallucination d’IA est associée à des réponses ou des croyances injustifiées. Bref, les hallucinations se produisent lorsque le modèle d’IA produit des informations incorrectes, trompeuses ou inventées de toutes pièces. À noter que certains chercheurs en IA s’opposent à l’utilisation du mot hallucination car cela sous-entend que les IA auraient une forme de conscience, ce qui n’est pas le cas.

Quand tu utilises une IA, vérifie toujours les principales informations de la réponse formulée, ainsi que les données chiffrées. Tu peux aussi demander à l’IA quelles sont ses sources !

Pourquoi une IA hallucine-t-elle ?

Tout dépend de la manière dont les modèles ont été formés. Les modèles d’IA sont entraînés sur des données et apprennent à réaliser des prédictions en identifiant des tendances récurrentes parmi ces données. Cependant, la justesse de ces prédictions dépend souvent de la qualité et de l’exhaustivité des données d’entraînement. Si les données d’entraînement sont incomplètes, biaisées, erronées ou pas mises à jour, le modèle d’IA peut apprendre des schémas incorrects, ce qui peut conduire à des prédictions inexactes ou à des hallucinations.

Un autre facteur qui peut contribuer à créer des hallucinations est le manque d’ancrage. Un modèle d’IA peut avoir des difficultés à comprendre avec précision des connaissances du monde réel, des propriétés physiques ou des informations factuelles.

Pourquoi est un problème majeur pour les IA ?

Une réponse fournie par une IA générative, comme ChatGPT, peut sembler très réaliste. Contrairement à un moteur de recherche qui te fournit une liste de liens en réponse à une requête, une IA va t’écrire un texte construit avec une réponse unique qui ressemble à une conversation. La réponse d’une IA peut paraître alors très persuasive, surtout si elle contient des erreurs et des faits inventés entremêlés avec des informations correctes.

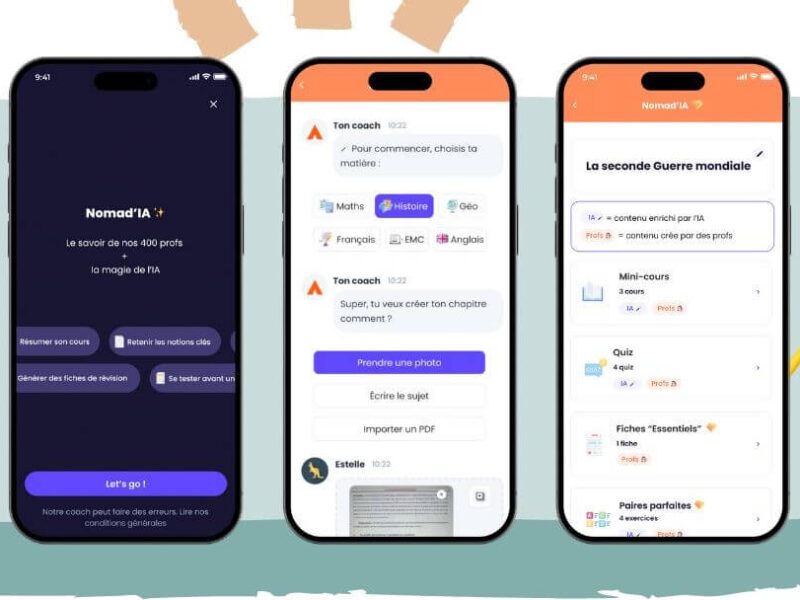

À regarder

Cette vidéo courte de Thomas Solignac qui te résume tout en 1 mn :